Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。

robots.txt文件是一个文本文件,使用任何一个常见的文本编辑器,比如Windows系统自带的Notepad,就可以创建和编辑它robots.txt是一个协议,而不是一个命令。robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

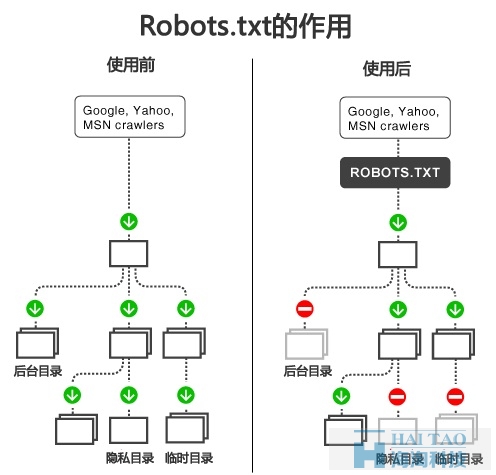

当一个搜索蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。百度官方建议,仅当您的网站包含不希望被搜索引擎收录的内容时,才需要使用robots.txt文件。如果您希望搜索引擎收录网站上所有内容,请勿建立robots.txt文件。

如果将网站视为酒店里的一个房间,robots.txt就是主人在房间门口悬挂的“请勿打扰”或“欢迎打扫”的提示牌。这个文件告诉来访的搜索引擎哪些房间可以进入和参观,哪些房间因为存放贵重物品,或可能涉及住户及访客的隐私而不对搜索引擎开放。但robots.txt不是命令,也不是防火墙,如同守门人无法阻止窃贼等恶意闯入者。

大家都知道,robots.txt文件在网站优化时,是一个很重步骤,正确的写好我们的robots.txt有利于我们的优化,首先我们要知道它是一种协议,也可以说是爬虫协议、机器人协议。它的作用就是告诉搜索引擎蜘蛛我们的网站那些页面可以被抓取,那些不可以抓取,所以这步对SEO网站优化很重要,但这一步也是要非常认真的写,一旦写错,那对自己网站会很严重,比如一个目录写错了,那么会导致这个目录里的东西不被抓取,所以我们必须要了解我们网站的架构,每个目录我们都要知道它是什么意思,这样有利于我们写好robots.txt协议,在没有搞懂自己网站的架构之前,最好不要去写robots.txt。先搞懂再说。下面我就来讲讲制作方法及怎么去使用:

大家首先要知道两个标签,Allow和Disallow,一个是允许,一个是不允许,它的作用相比大家也都能理解。大家一定不要搞混了,还有一个符号:* 这个符号代表:所有的意思。

User-agent: *

Disallow:

或者

User-agent: *

Allow:

如果我想屏蔽搜搜的蜘蛛来抓取,

User-agent: sosospider

Disallow: /

大家可以发现这个屏蔽蜘蛛跟上面允许相比只是多了一个“/”,其含义是完全不一样的,所以在书写的时候要千万注意,可不能因为多写个斜杠屏蔽了蜘蛛自己却不知道。还有就是在user-agent:后边不屑固定蜘蛛名称跟的如果是“*”表示是针对所有蜘蛛的。

我们要禁止网站那个目录文件不允许搜索引擎蜘蛛来抓取:

User-agent: *

Disallow: /目录/。

如果是阻止抓取某目录的话目录名字一定要注意“/”,不带“/”表示的是阻止访问这个目录页面和目录下的页面,而带上“/”则表示进阻止目录下的内容页面,这两点要分清楚。如果是想屏蔽多个目录就需要采用的。

如果是阻止蜘蛛访问某一类型的文件,例如阻止抓取.jpg格式的图片可以设置成:

User-agent: *

Disallow: .jpg$

假如我网站很多页面后缀带有?号的目录,怎么来写呢!我们可以这样写;

User-agent: *

Disallow: /*?

最后大家,写robots.txt的时候,一定要分清字母的大小写,还要robots.txt写好都是放到网站根目录下面。大家对网站robots.txt文件的制作已经了解了吗?